어떤 확률변수 $X$가 확률분포 $p(x)$를 따른다고 할 때, 이 확률변수에 특정한 결정적 변환(determistic transformation) $y = f(x)$를 적용하면 새로운 확률변수 $Y$가 만들어집니다. 오늘은 변환으로 새롭게 얻은 확률변수 $Y$의 확률분포 $p(y)$의 특성을 다루어보도록 하겠습니다.

1. 이산형 확률변수의 경우

만약 $X$가 이산형 확률변수인 경우 새로운 확률변수 $Y = f(X)$의 PMF를 구해보겠습니다. 즉, $Y$가 특정한 값 $y$를 가질 확률 $p_{y}(y)$는 원래 확률변수 $X$의 값들 중에서 $f(x) = y$라는 조건을 만족하는 모든 $x$들의 확률을 합산하는 것과 동일하므로 다음과 같이 계산할 수 있습니다.

$$p_{y}(y) = \sum_{x:f(x) = y} p_{x}(x)$$

이 식의 의미를 좀 더 쉽게 분석해보면 원래 확률변수 $X$에서 변환을 통해 새롭게 만들어진 값이 $y$가 되는 모든 경우들을 찾아서 그 경우들의 원래 확률을 다 더해주는 것 입니다. 말로만 하면 어려우니 쉬운 예시를 들어보죠.

$X$가 $\{1, 2, 3, \dots, 10\}$에서 균등한 확률분포를 따른다고 가정하면 각 숫자가 나올 확률은 $\frac{1}{10}$ 입니다. 이때, 확률변수 $Y = f(X)$를 만약 $X$가 짝수인 경우 $f(X) = 1$이 되고 $X$가 홀수인 경우 $f(X) = 0$으로 정의된다고 하겠습니다. 이 경우 $Y$의 확률분포는 다음과 같이 계산됩니다.

- $Y = 1$일 확률은 곧 $X$가 짝수 $\{2, 4, 6, 8, 10\}$이 나올 확률을 합산한 것과 동일하므로 $5 \times \frac{1}{10} = \frac{1}{2}$입니다.

- $Y = 0$일 확률은 곧 $X$가 홀수 $\{1, 3, 5, 7, 9\}$이 나올 확률을 합산한 것과 동일하므로 $5 \times \frac{1}{10} = \frac{1}{2}$입니다.

이 예시에서 알 수 있듯이, 확률변수의 변환함수 $f$는 다대일(many-to-one)인 경우가 많습니다. 즉, 여러 개의 다른 $x$값이 동일한 하나의 $y$값으로 변환되는 경우가 흔히 발생합니다.

2. 연속형 확률변수의 경우

확률변수 $X$가 연속형일 경우에는 PDF를 사용하게 됩니다. 즉, 기존의 이산형 확률변수에서 사용하던 방식이 아닌 CDF를 이용하여 새로운 확률분포 $Y = f(X)$의 확률분포를 계산해야합니다. 연속형 확률변수의 경우, 변환된 확률변수 $Y$의 CDF를 다음과 같이 계산합니다.

$$P_{y}(Y) = \text{Pr}(Y \le y) = \text{Pr}(f(X) \le y) = \text{Pr}(X \in \{ f(x) \le y \})$$

이 식을 쉽게 풀어서 설명하면, 확률변수 $Y$가 특정 값 $y$ 이하의 값을 가질 확률은 원래 확률변수 $X$가 변환 함수 $f(x)$의 값이 $y$ 이하가 되는 모든 경우에 해당하는 확률과 같다는 의미입니다. 만약, 변환함수 $f(x)$가 역함수를 가지는 경우라면 $Y$의 PDF를 얻기 위해 누적분포함수 $P_{y}(y)$를 미분하여 쉽게 구할 수 있습니다. 그러나 만약 변환함수 $f(x)$가 역함수를 가지지 않는 경우라면 $Y$의 분포를 구하기 위해서는 수치적 적분(Numerical Integration)이나 몬테카를로 근사법(Monte Carlo Approximation)과 같은 방법들을 사용해야합니다.

2.1 역함수가 존재하는 확률변수의 변환 (Invertible transformations)

이제 특별히 단조(monotonic) 함수이면서, 따라서 역함수가 존재하는 경우(invertible, bijection)에 대해 살펴보겠습니다. (여기서 함수가 역함수를 가진다는 것은 일대일 대응(bijection)을 의미합니다.) 이 가정 아래에서는 변환된 확률변수의 PDF를 계산하는 간단한 공식이 존재합니다. (비단조(non-monotonic) 함수에서도 일반화할 수 있으나, 여기서는 다루지 않습니다.)

2.1.1 변수 변환 공식: 스칼라 경우

먼저 예시를 통해 이해해봅시다. 확률변수 $x$가 구간 $(0, 1)$에서 균등분포 $X \sim \text{Unif}(0, 1)$을 따른다고 가정하겠습니다. 그리고 새로운 확률변수를 $y = f(x) = 2x + 1$이라고 정의하겠습니다. 이 함수는 원래 확률분포를 두 배로 늘이고 1만큼 이동시키는 결과를 얻습니다 (그림 2.19 참고). 이제 구간에서 한 점 $x$와 그것보다 미세하게 다른 점 $x + dx$를 생각해보겠습니다. 이 구간은 변환 $f(x)$를 적용하면 $f(x)$의 가정에 의해 $(y, y + dy)$라는 새로운 구간으로 대응됩니다.

확률의 관점에서 바라보면 원래 구간 $(x, x + dx)$와 새로운 구간 $(y, y + dy)$는 동일한 확률을 가져야하므로 $p(x)dx = p(y)dy$가 되어야합니다. 따라서, PDF를 다음과 같이 쓸 수 있죠.

$$p(y) = p(x) \frac{dx}{dy}$$

그러나 미분값 $\frac{dx}{dy}$가 양수인지 음수인지는 중요하지 않고 절댓값만 중요하므로 일반적으로 다음과 같은 공식으로 표현합니다.

$$p_{y}(y) = p_{x}(x) \left| \frac{dx}{dy} \right|$$

이것이 변수 변환 공식(change of variables formula)입니다. 자 이제 좀 더 일반적인 경우를 생각해보겠습니다. 임의의 PDF $p_{x}(x)$가 임의의 단조증가 함수 $f: \mathbb{R} \rightarrow \mathbb{R}$가 있다고 가정하겠습니다. 이 함수의 역함수를 $g = f^{-1}$로 나타내면, 다음과 같은 식을 얻습니다.

$$P_{y}(y) = \text{Pr}(f(X) \le y) = \text{Pr}(X \le f^{-1}(y)) = P_{x}(f^{-1}(y)) = P_{x}(g(y))$$

이제 이 CDF를 미분하면 확률변수 $Y$의 PDF를 구할 수 있습니다. 여기서 연쇄법칙을 적용하면 됩니다.

$$p_{y}(y) = \frac{d}{dy} P_{y}(y) = \frac{d}{dy} P_{x}(g(y)) = \frac{dx}{dy} \frac{d}{dx} P_{x}(g(y)) = \frac{dx}{dy} p_{x}(g(y))$$

단조감소 함수인 경우에도 유사한 공식을 얻을 수 있으나, 이때는 미분값의 부호가 반대가 됩니다. 두 경우를 통합하여 보다 일반적인 형태로 표현하면 다음과 같습니다.

$$p_{y}(y) = p_{x}(g(y)) \left| \frac{d}{dy} g(y) \right|$$

이 공식이 바로 "변수 변환 공식(change of variables formula)"입니다. 간단하게 정리하자면 역함수가 존재하는 변환의 경우, 새로운 확률변수의 PDF는 원래 변수의 PDF에 역함수의 미분의 절댓값을 곱한 형태로 간단히 표현할 수 있습니다.

2.1.2 다변수 확률변수의 변환: 다변량 변수 변환 공식

이전의 결과는 하나의 확률변수의 경우였지만, 이를 여러 개의 확률변수로 구성된 다변량(multivariate) 확률변수의 경우로 확장할 수 있습니다. $f: \mathbb{R}^{n} \rightarrow \mathbb{R}^{n}$으로 대응되는 역함수가 존재하는 함수라고 하고, 그 역함수를 $g$라고 합시다. 이제 확률변수의 변환을 $y = f(x)$라고 하겠습니다. 이 변환된 확률변수 $y$의 PDF는 다음과 같이 계산됩니다.

$$p_{y}(y) = p_{x}(g(y)) |\text{det}(\mathbf{J}_{g}(y))|$$

여기서 $\mathbf{J}_{g} = \frac{dg(y)}{dy^{T}}$는 역함수 $g(y)$의 야코비안(Jacobian) 행렬입니다. 그리고 $ |\text{det}(\mathbf{J}_{g}(y))| $은 이 야코비안 행렬의 행렬식의 절댓값이죠. 야코비안(Jacobian)에 대한 더 자세한 설명은 이후에 더 진행하도록 하겠습니다.

이를 2차원에서 선형 변환을 예로 들어 살펴보겠습니다. $\mathbf{A} = \begin{pmatrix} a & c \\ b & d \end{pmatrix}$라고 할 때 $f(x) = \mathbf{A}x + \mathbf{b}$라고 가정하겠습니다. 이 변환에서 단위 정사각형(unit square)의 면적이 어떻게 바뀌는지 살펴봅시다. 이 변환을 적용하면, 단위 정사각형은 일반적으로 평행사변형(parallelogram)이 됩니다 (그림 2.20 참고). 이때 평행사변형의 면적은 정확히 행렬 $A$의 행렬식 $\text{det}(A) = ad - bc$배만큼 확대되거나 축소됩니다. 즉, 원래의 면적에 이 행렬식을 곱한 값이 새로운 면적이 되는 것입니다.

다른 예시로 카테시안 좌표계(cartesian coordinates)에서 극좌표(polar coordinates)로 변환하는 경우를 살펴보겠습니다. 다음과 같은 변환을 생각합시다. 카테시안 좌표는 $x = (x_{1}, x_{2})$ 그리고 극좌표는 $y = (r, \theta)$라고 가정하겠습니다. 그러면 변환함수는 $g(r, \theta) = (r\cos\theta, r\sin\theta)$로 정의됩니다. 이 변환의 야코비안 행렬은 다음과 같이 계산됩니다.

$$\mathbf{J}_{g} = \begin{pmatrix} \frac{\partial x_{1}}{\partial r} & \frac{\partial x_{1}}{\partial \theta} \\ \frac{\partial x_{2}}{\partial r} & \frac{\partial x_{2}}{\partial \theta} \end{pmatrix} = \begin{pmatrix} \cos\theta & -r\sin\theta \\ \sin\theta & r\cos\theta \end{pmatrix}$$

이 야코비안의 행렬식은 다음과 같습니다:

$$|\text{det}(\mathbf{J}_{g})| = |r\cos^{2} \theta + r\sin^{2} \theta| = |r|$$

이제 극좌표로 표현된 확률밀도함수는 다음과 같은 공식으로 표현됩니다:

$$P_{r, \theta} (r, \theta) = p_{x_{1}, x_{2}} (r\cos(\theta), r\sin(\theta)) r$$

이 식을 좀 더 직관적으로 기하학적으로 보면, 극좌표계에서는 미소한 면적요소 $dA$가 $rdrd\theta$의 형태로 표현됩니다 (그림 2.21 참고). 따라서, 극좌표에서의 미소영역에서의 확률은 다음과 같습니다.

$$\text{Pr}(r \le R \le r + dr, \theta \le \Theta \le \theta + d\theta) = p_{r, \theta} (r, \theta) drd\theta$$

극한을 취하면 이 미소 면적요소의 확률은 중심점의 확률밀도와 면적 $rdrd\theta$의 곱이 되므로 $p_{r, \theta} (r, \theta) drd\theta = p_{x_{1}, x_{2}}(r\cos\theta, r\sin\theta) rdrd\theta$ 가 성립하는 것입니다.

3. 선형 변환된 확률변수의 평균과 분산 (Moments of a linear transformation)

이번에는 확률변수의 변환 함수 $f$가 아핀변환일 경우 평균과 공분산을 계산하는 방법에 대해서 알아보도록 하겠습니다. 확률변수 $x$가 있다고 가정하고 여기에 $y = \mathbf{A}x + \mathbf{b}$라는 아핀변환을 적용했다고 가정하면 $y$의 평균과 공분산은 다음과 같이 구할 수 있습니다.

3.1 평균의 계산

먼저 평균부터 살펴보겠습니다. 평균을 계산할 때, 기대값($\mathbb{E}$)을 취하면 변환이 매우 간단해집니다. 확률변수 $x$의 평균을 $\mu = \mathbb{E}[x]$라고 하면 $\mathbb{E}[y] = \mathbb{E}[\mathbf{A}x + \mathbf{b}] = \mathbf{A}\mu + \mathbf{b}$가 성립합니다.

즉, 평균을 계산할 때는 원래 확률변수의 평균에 변환 행렬 $\mathbf{A}$를 곱한 뒤, 상수 $\mathbf{b}$를 더해주기만 하면 됩니다. 특히 변환 함수 $f$가 스칼라 값을 가지는 경우 $f(x) = \mathbf{a}^{T}x + \mathbf{b}$라면 $\mathbb{E}[\mathbf{a}^{T}x + \mathbf{b}] = \mathbf{a}^{T}\mu + \mathbf{b} $로 쉽게 구할 수 있습니다.

3.2 공분산의 계산

공분산의 경우에도 선형 변환에 대한 공식이 매우 간단합니다. 원래 확률변수 $x$의 공분산을 $\Sigma = \text{Cov}[x]$라고 하면 변환 후 확률변수 $y$의 공분산은 다음과 같이 계산됩니다.

$$\text{Cov}[y] = \text{Cov}[\mathbf{A}x + \mathbf{b}] = \mathbf{A}\Sigma\mathbf{A}^{T}$$

위 수식에 대한 증명은 다음을 참고해주세요.

확률변수 $x$가 있고 이에 대해 아핀변환을 적용한 새로운 확률변수 $y$가 $y = \mathbf{A}x + \mathbf{b}$로 주어졌다고 가정하자. 여기서 $\mathbf{A}$와 $\mathbf{b}$는 각각 상수행렬과 상수벡터이다.

기존의 확률변수 $x$의 공분산은 $\text{Cov}[x] = \Sigma = \mathbb{E}[(x - \mu)(x - \mu)^{T}]$로 계산할 수 있다. 이때, 변환된 확률변수 $y$의 공분산을 정의에 따라 구하면 다음과 같다.

$$\text{Cov}[y] = \mathbb{E}[(y - \mathbb{E}[y])(y + \mathbb{E}[y])^{T}]$$

이때, $\mathbb{E}[y] = \mathbb{E}[\mathbf{A}x + \mathbf{b}] = \mathbf{A}\mu + \mathbf{b}$로 쉽게 구할 수 있고 이를 다시 대입하자.

$$\text{Cov}[y] = \mathbb{E}[((\mathbf{A}x + \mathbf{b}) - (\mathbf{A}\mu + \mathbf{b}))((\mathbf{A}x + \mathbf{b}) + (\mathbf{A}\mu + \mathbf{b}))^{T}] = \mathbb{E}[(\mathbf{A}(x - \mu))(\mathbf{A}(x - \mu))^{T}]$$

행렬 곱셈과 기댓값의 성질에 따라 다음과 같이 전개된다.

$$\text{Cov}[y] = \mathbb{E}[\mathbf{A}(x - \mu)(x - \mu)^{T}A^{T}] = \mathbf{A}\mathbb{E}[(x - \mu)(x + \mu)^{T}]A^{T} = \mathbf{A} \Sigma \mathbf{A}^{T}$$

특히 스칼라 형태의 변환 $y = \mathbf{a}^{T}x + \mathbf{b}$일 경우, 공분산은 분산이라는 스칼라 형태로 표현되어 $\mathbb{V}[y] = \mathbb{V}[\mathbf{a}^{T}x + \mathbf{b}] = \mathbf{a}^{T}\Sigma \mathbf{a}$가 됩니다. 이 공식은 자주 쓰이는 형태이므로 잘 기억해두는 것이 좋습니다.

다음 예시로 확률변수 두 개의 합의 분산을 계산하는 과정을 살펴보겠습니다. 확률변수 두 개의 합 $x_{1} + x_{2}$의 분산을 계산한다고 가정하면 $\mathbf{a} = [1, 1]$로 두어 다음과 같이 표현할 수 있습니다.

$$\begin{align} \mathbb{V}[x_{1} + x_{2}] &= \begin{pmatrix} 1 & 1 \end{pmatrix} \begin{pmatrix} \Sigma_{11} & \Sigma_{12} \\ \Sigma_{21} & \Sigma_{22} \end{pmatrix} \begin{pmatrix} 1 \\ 1 \end{pmatrix} \\ &= \Sigma_{11} + \Sigma_{22} + 2\Sigma_{12} \\ &= \mathbb{V}[x_{1}] + \mathbb{V}[x_{2}] + 2\text{Cov}[x_{1}, x_{2}] \end{align}$$

두 확률변수의 합의 분산은 각 변수의 분산의 합에 두 변수 사이의 공분산을 두 배 더한 형태로 표현됩니다. 한 가지 기억할 점은, 가우시안 분포와 같은 특별한 분포는 평균과 공분산만으로 그 분포를 완전히 나타낼 수 있지만, 일반적인 경우엔 평균과 공분산만으로는 충분하지 않다는 것입니다. 즉, 선형 변환된 확률변수의 전체적인 분포를 얻으려면 앞서 배웠던 "변수 변환 공식" 등 더 구체적인 방법을 활용해야 합니다.

4. 중심극한정리 (Central Limit Theorem)

이번엔 통계학과 확률이론에서 매우 중요하게 여겨지는 중심극한정리(Central Limit Theorem)에 대해 알아보겠습니다. 중심극한정리는 확률변수들의 합이 많아질수록 그 합의 분포가 정규분포에 가까워진다는 이론입니다.

4.1 중심극한정리의 직관적 의미

평균이 $\mu$, 분산이 $\sigma^{2}$ 인 임의의 확률분포에서 독립적으로 표본을 여러 번 추출한다고 생각합시다. 이렇게 추출한 독립이고 동일한 분포(i.i.d., independent and identically distributed)를 따르는 확률변수들의 합을 계산합니다. 중심극한정리는 표본의 개수 $N$ 이 충분히 클 때, 이 확률변수들의 합이 정규분포에 매우 가까워진다는 것입니다. 즉, 처음의 분포가 무엇이든지 상관없이, 많은 확률변수의 합이나 평균을 구하면 그 결과는 점점 더 "종 모양(bell shape)"의 정규분포를 따르게 됩니다.

4.2 중심극한정리의 수학적 표현

$N$개의 확률변수 $X_{1}, X_{2}, \dots, X_{N}$들이 서로 독립적이고 각각의 확률변수는 평균 $\mu$ 그리고 분산 $\sigma^{2}$를 가진다고 가정하고 합을 $S_{N} = \sum_{n = 1}^{N} X_{n}$이라고 두겠습니다. 그러면 중심극한정리는 표본 수 $N$이 매우 클 때 이 합의 확률분포가 다음과 같은 형태로 정규분포에 가까워짐을 설명합니다.

$$p(S_{N} = u) = \frac{1}{\sqrt{2\pi N \sigma^{2}}} \text{exp} \left( -\frac{(u - N\mu)}{2N\sigma^{2}} \right)$$

더 구체적으로는 다음과 같은 표준화를 한 확률변수 $Z_{N}$의 분포가 표준정규분포 $\mathcal{N}(0, 1)$으로 수렴하게 됩니다.

$$Z_{N} = \frac{S_{N} - N_{\mu}}{\sigma \sqrt{N}} = \frac{\bar{X} - \mu}{\frac{\sigma}{\sqrt{N}}}$$

여기서 $\bar{X}$는 확률변수들의 표본 평균(sample mean)을 의미합니다.

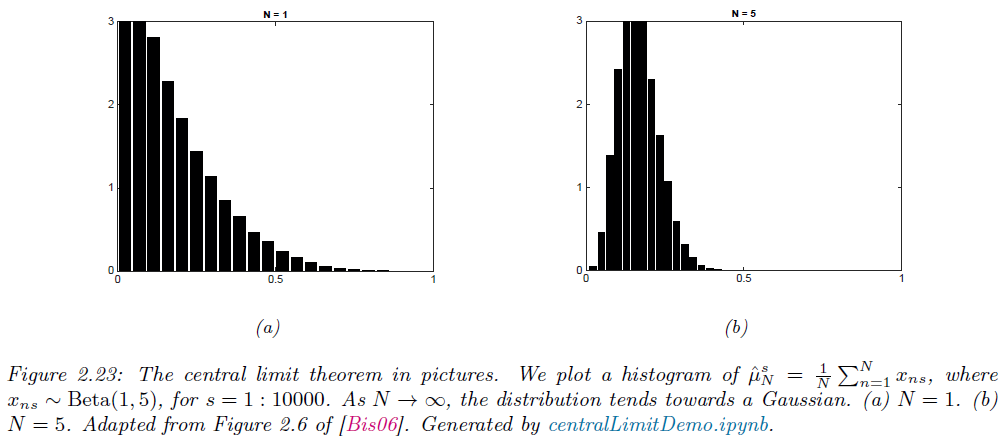

간단한 예시를 들어 설명해보도록 하겠습니다. 베타 분포는 정규분포와 매우 다른 모양을 가지는 분포입니다. 하지만 중심극한정리의 예시로 베타분포에서 추출한 확률변수들의 평균을 구해보면 흥미로운 결과를 얻을 수 있습니다. 처음에는 베타 분포에서 추출한 확률변수 하나의 분포는 정규분포와 다를 수 있습니다. 그러나 이 확률변수의 평균을 표본의 크기 $N$ 이 점점 더 클수록(10, 50, 100 등), 그 평균의 분포는 매우 빠르게 정규분포 형태로 수렴하게 됩니다 (그림 2.23). 즉, 본래 분포의 모양과는 관계없이 확률변수들의 평균이나 합은 정규분포 형태를 띄게 되는 것입니다.

중심극한정리가 중요한 이유는 현실에서 자주 접하는 데이터가 종종 여러 확률변수들의 합이나 평균으로 구성되어 있기 때문입니다. 측정 오차, 실험 데이터, 여론조사 결과, 수익률 등 수많은 현실적인 데이터들은 다양한 요소들이 합쳐져 나타나기 때문에 대체로 정규분포와 비슷한 모양을 가집니다. 따라서, 중심극한정리는 현실 데이터의 통계적 분석을 위한 이론적 근거를 제공하는 중요한 역할을 합니다.

5. 몬테카를로 근사법 (Monte Carlo approximation)

확률변수 $x$가 있을 때 이를 변환한 확률변수 $y = f(x)$의 확률변수 $p(y)$를 정확하게 해석적으로 계산하는 것은 어려울 수 있습니다. 이때 매우 간단하면서도 강력한 대안이 있는데 그것이 바로 몬테카를로(Monte Carlo) 근사법입니다. 몬테카를로 근사법은 원래 확률변수 $x$의 분포로부터 많은 수의 표본의 무작위로 더 추출한 다음, 이 표본을 사용하여 변환된 확률변수 $y$의 분포를 근사하는 방법입니다. 기본적인 단계는 다음과 같습니다.

STEP1. 확률변수 $x$로부터 임의로 더 많은 샘플을 뽑는다.

STEP2. 각 샘플에 대해 변환 $y = f(x)$을 적용한다.

STEP3. 변환된 값 $y$들의 집합을 가지고 경험적 확률분포를 생성하여 실제 확률분포 $p(y)$를 근사한다.

예를 들어, 다음과 같은 간단한 상황을 생각해 봅시다. 기존의 확률변수 $x \sim \text{Uniform}(-1, 1)$, 즉 균등분포에서 뽑혔다고 가정하고 변환함수는 $y = f(x) = x^{2}$이라고 하겠습니다. 이때, $y$의 확률분포를 몬테카를로 근사법을 사용하여 찾아보도록 하겠습니다. 방법은 다음과 같습니다.

STEP1. 균등분포에서 매우 많은 수의 샘플 $\{x_{1}, x_{2}, \dots, x_{N}\}$을 무작위로 추출한다.

STEP2. 각 샘플을 제곱하여 $y_{s} = x_{s}^{2}$을 구한다.

STEP3. 이러한 샘플들로부터 경험적 분포를 생성합니다. 즉, 각 샘플 $y_{s}$에서의 PDF를 다음과 같이 정의한다.

$$p_{s}(y) = \frac{1}{N_{s}} \sum_{s = 1}^{N_{s}} \delta(y - y_{s})$$

이 경험적 분포는 각 표본 지점에서 동일한 가중치의 "스파이크"의 합입니다. 여기서 $\delta$ 는 디랙 델타 함수로, 특정 지점에서만 값을 가지는 함수입니다.) 충분히 많은 샘플 $N_{s}$를 사용하면 이 경험적 분포는 실제의 확률분포 $p(y)$ 에 매우 가까워집니다 (그림 2.24 참고).