Background

최근 온디바이스 환경에서는 저장공간 및 연산량 제약이 큰 상황에서도 분류뿐만 아니라 검출과 분할 같은 dense prediction을 안정적으로 수행할 수 있는 경량 비전 모델이 요구된다. 기존 경량 CNN 계열은 MobileNet 계열의 depth-wise separable convolution과 MobileNetV2의 Inverted Residual Block (IRB)을 핵심 인프라로 삼아 파라미터와 FLOPs를 크게 낮춰왔다. 그러나 CNN의 정적 가중치로 인해 발생하는 inductive bias만으로는 성능 상한이 뚜렷하고 반대로 ViT 이후의 어텐션 기반 모델은 장거리 의존성 모델링과 대규모 데이터 학습에서 강점이 있지만 고해상도에서의 MHSA 계산 복잡도가 커서 모바일 배포가 어렵다.

이러한 문제를 해결하기 위해 몇 가지 접근법이 제시되어 왔다. 대표적으로 1) 효율적 CNN 블록 (SqueezeNet, Inception류의 factorization, MobileNet류의 분해합성곱, NAS 기반 설계), 2) CNN-Transformer 하이브리드(Conv를 FFN/토큰 믹싱/위치정보로 주입해 지역 귀납 편향을 보강), 3) 효율적 Transformer 경량화(로컬 윈도우, 병렬 구조, Conv 차용, EdgeNeXt/EdgeViT류의 복합 모듈)로 전개돼 왔다. 특히, MobileViT는 성능 향상을 보였지만 상대적으로 FLOPs가 높고 모듈 구성이 복잡해지며 EdgeNeXt/EdgeViT 역시 정교한 구성 요소로 인해 사용성 및 균일성 측면에서 불리하다는 지적이 있다. 결국 IRB에 준하는 어텐션 기반 경량 인프라 블록이 부재하다는 점이 남아있었고, 이는 블록 수준에서의 단순성, 배포 친화성과 같은 성능을 동시에 만족시키는 설계로 이어지기는 어려웠다.

본 논문에서는 이러한 공백을 겨냥해 IRB와 Transformer의 핵심 구성요소 (MHSA/FFN)을 하나의 관점으로 재정의하고 확장비와 효율연산자로 모듈을 인스턴스화하는 one-residual Meta Mobile Block (MMB)를 제안한다. 즉, 세가지의 서로 다른 모듈이였던 IRB, MHSA, FFN이 공유하는 공통 구조를 드러내는 메타 블록을 먼저 귀납적으로 정의하고 이를 바탕으로 DW-Conv와 개선된 윈도우 기반 어텐션 (EW-MHSA)만으로 구성된 Inverted Residual Mobile Block (iRMB)을 연역적으로 설계하여 단일 블록 중심의 ResNet-like 백본 EMO로 확장한다. 이러한 접근은 복잡한 특수 모듈을 추가하지 않으면서도 경량 어텐션 모델의 설계 기준(단순 구현, 모듈 균일성, 성능, 효율)을 동시에 만족시키는 방향을 제시한다.

Methodology: Induction and Deduction

1) Criteria for General Efficient Model

본 논문의 저자들은 모바일 및 엣지용 경량 비전 모델을 설계할 때 효율적(efficiency)라는 말을 단순히 파라미터 및 FLOPs의 감소로만 보지 않고 현실적인 배포 및 운용 관점까지 포함한 4가지 기준을 제안한다. 이를 정리하면 다음과 같다.

① Usability (사용성): 구현이 단순하고, 복잡한 연산자를 쓰지 않아 최적화/배포가 쉬운 구조일 것.

② Uniformity (균일성): 핵심 모듈 종류를 최소화해 모델 복잡도를 낮추고 배포를 가속할 것(“블록이 많고 다양하면” 유지보수와 최적화가 어려워짐).

③ Effectiveness (효과성): ImageNet 분류뿐 아니라 검출/분할 같은 dense prediction에서도 성능이 잘 나올 것.

④ Efficiency (효율성): 정확도를 크게 희생하지 않으면서 파라미터·연산량이 적을 것.

그리고 이 4가지 기준으로 Table 1과 같이 기존 계열을 간단하게 진단한다. MobileNet 계열은 전반적으로 성능이 약간 낮고 파라미터가 약간 높은 편으로 평가하고 MobileViT 계열은 성능은 좋지만 FLOPs가 크고 모듈이 다소 복잡하다는 점을 지적한다. EdgeNeXt와 EdgeViT는 결과는 좋지만 기본 블록 자체가 복잡한 모듈 조합으로 이루어져 있다는 문제 의식을 제시한다. 하지만 본 논문에서 제안하는 EMO는 이 4가지 기준을 전부 만족하는 모습을 볼 수 있다.

2) Meta Mobile Block (MMB)

2-1) Motivation

저자들은 모바일 및 경량 CNN의 표준 인프라가 IRB로 굳어져 있는 반면 어텐션 기반 경량 모델에는 IRB와 대응되는 보편적 기본 블록이 정립되지 않았다고 보았다. 그래서 IRB의 장점인 단순하면서도 효율적인 구조를 어텐션 모델로 옮기려는 과정에서 Transformer의 두 핵심 서브 모듈 (MHSA와 FFN)이 구조적으로 IRB와 유사한 공통 골격을 갖는다는 점에 주목하고 이를 일반화하였다.

2-2) Induction

MMB는 확장(Expand) → 핵심 연산(Operator) → 축소(Shrink) + 잔차(Residual) 라는 한 번의 residual로 정리되는 메타 구조이다. 먼저, 입력 특징 맵 $\mathbf{X} \in \mathbb{R}^{C \times H \times W}$에 대해서 채널 확장 $\text{MLP}_{e}$을 통해서 확장비 $\lambda$만큼 채널을 늘려준다. 다음으로 효율 연산자 $\mathcal{F}$를 이용해서 특징을 강화(Identity, Conv, MHSA, ...)을 수행한다. 그리고 다시 채널 축소 $\text{MLP}_{s}$를 통해 원래의 채널 개수로 복원한 뒤 잔차 연결을 수행한다. 이 과정을 수식적으로 정리하면 다음과 같다.

$$\begin{cases} \mathbf{X}_{e} &= \text{MLP}_{e} (\mathbf{X}) \in \mathbb{R}^{\lambda C \times H \times W} \\ \mathbf{X}_{f} &= \mathcal{F}(\mathbf{X}_{e}) \in \mathbb{R}^{\lambda C \times H \times W} \\ \mathbf{X}_{s} &= \text{MLP}_{s} (\mathbf{X}_{f}) \in \mathbb{R}^{C \times H \times W} \\ \mathbf{Y} &= \mathbf{X} + \mathbf{X}_{s} \end{cases}$$

여기서 핵심은 그림 2와 같이 MMB가 확장비 $\lambda$와 효율 연산자 $\mathcal{F}$라는 두 개의 인자로 IRB, MHSA, FFN을 한 틀에 인스턴스화 할 수 있는 메타-패러다임이라는 것이다.

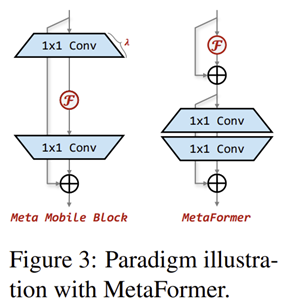

2-3) Relation to MetaFormer

그림 3은 MetaFormer와 MMB 사이의 구조적 차이점을 보여주고 있다. 저자들은 MetaFormer가 “고성능 Transformer/MLP류”를 추상화한 반면, MMB는 ‘경량 인프라’ 관점에서 IRB(모바일 CNN) + MHSA/FFN(Transformer)의 공통 본질을 추상화했다고 구분한다. 또한 MetaFormer가 보통 두 개의 residual(두 서브모듈, 두 skip) 인 데 비해, MMB는 한 개 residual(한 서브모듈) 로 더 얕고 단순해 메모리 액세스/하드웨어 친화성 측면에서 유리하다고 주장한다.

3) Micro Design: Inverted Residual Mobile Block (iRMB)

iRMB는 앞서 유도한 Meta Mobile Block(MMB)을 “현실적으로 배포 가능한” 수준으로 구체화한 마이크로 블록이다. 핵심설계는 효율 연산자 $\mathcal{F}$를 어텐션 $\rightarrow$ 컨볼루션 캐스케이드 구조로 두어 전역 상호작용(Transformer의 동적 모델링)과 국소 특징(Conv의 효율성)을 동시에 가져오려는 것이다. 즉, $\mathcal{F}(\cdot) = \text{Conv}(\text{MHSA}(\cdot))$의 형태로 “긴 거리 상호작용 + 로컬 패턴”을 한 블록 안에서 처리하는 방향을 택한다.

다만 이 구성을 그대로(naive) 쓰면 모바일/엣지 관점에서 비용이 급증한다. 논문은 비용 문제를 두 가지로 정리한다. 1) MMB 구조 상 확장비 $\lambda > 1$를 쓰는 경우가 많아 중간 채널이 커지고 이때, 파라미터/연산이 $\lambda$에 대해 제곱적으로 증가하기 때문에 $\mathcal{F}$의 내부 구성요소는 채널 수에 독립적이거나 선형 의존이여야한다는 점. 2) MHSA는 픽셀 수에 대해 제곱적으로 FLOPs가 증가하므로 고해상도에서 감당이 어렵다.

이를 해결하기 위해 iRMB는 그림 4와 같이 $\mathcal{F}$는 EW-MHSA → DW-Conv + Skip로 재구성한다. 먼저, MHSA는 전역 대신 윈도우 기반 W-MHSA로 제한해 비용을 낮추고, 컨볼루션은 Depth-Wise Conv(DW-Conv) 를 사용해 채널 확장 상황에서도 비용 폭증을 억제한다. 특히 논문이 강조하는 개선점은 EW-MHSA(Expanded Window MHSA) 인데, 어텐션 행렬 계산에서 비싼 $Q$와 $K$를 확장된 특징 $\mathbf{X}_{e}$로 만들지 않고 원본 입력 $\mathbf{X}$로 두어 $Q = K = X$로 계산하며 $V$만 확장된 $\mathbf{X}_{e}$를 사용한다. 즉, 어텐션 맵은 저비용(비확장)으로 만들고, 표현력은 $V$ 확장으로 확보”하는 절충이다. 또한 이런 캐스케이딩은 수용영역 확장을 빠르게 하고, 최대 경로 길이(MPL)도 더 줄일 수 있다고 설명한다.

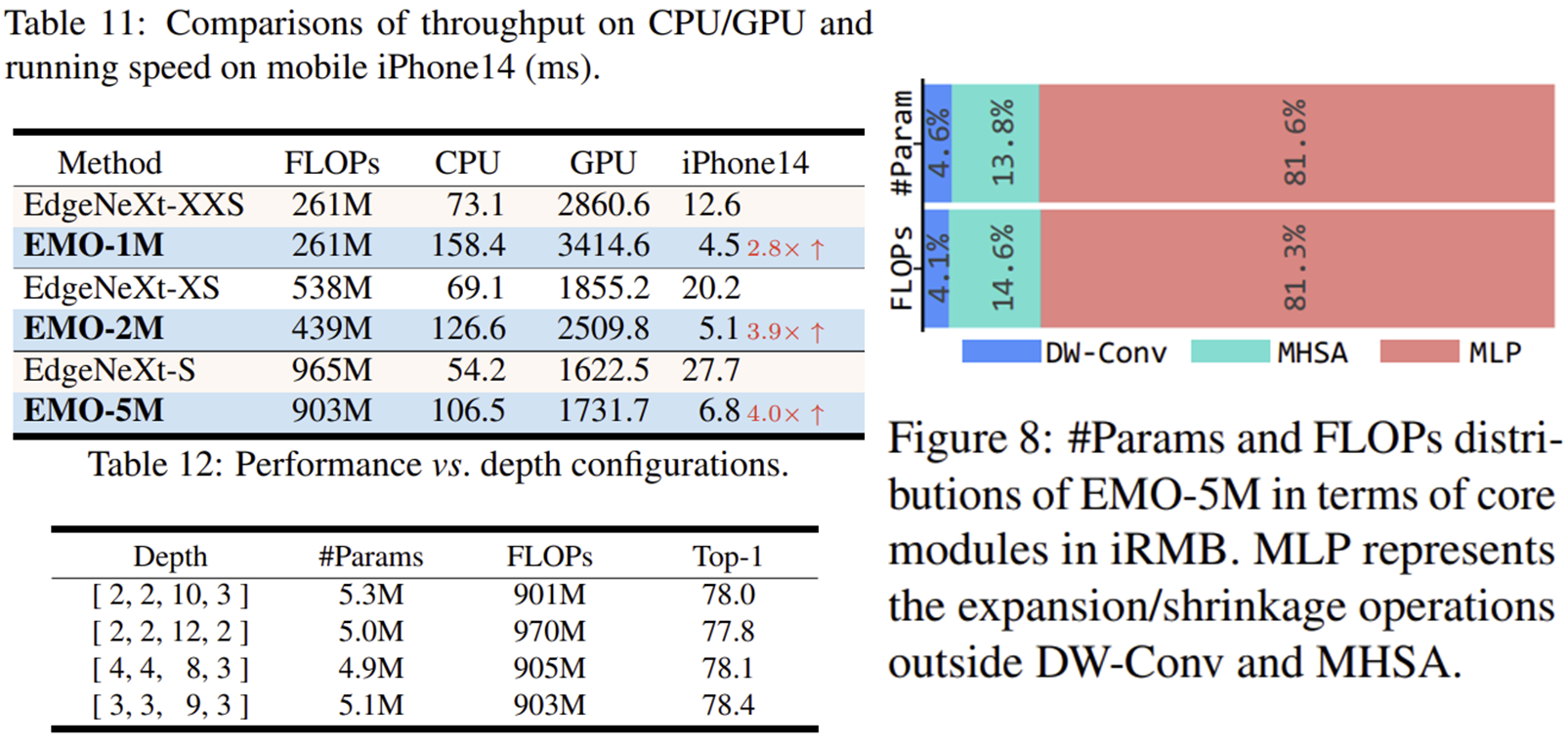

마지막으로 iRMB는 “블록을 여러 종류로 쪼개지 않으면서도(stage별) 동작을 바꿀 수 있게” 두 개의 스위치로 DW-Conv와 EW-MHSA 사용 여부를 제어하는 유연성(flexibility) 을 둔다. 즉 얕은 층에서는 CNN 성향(Conv 중심), 깊은 층에서는 Transformer 성향(어텐션 강화)이라는 경험적 합의를 단일 블록(iRMB) 내부 토글로 만족시키려는 전략이다.

4) Macro Design of EMO for Dense Prediction

위에서 제시한 기준에 기반하여 본 논문에서는 그림 2에서 보인것과 같이 dense application(예: 검출/분할 등)을 위해 일련의 iRMB들로 구성된 ResNet-like 4-phase Efficient MOdel(EMO) 을 설계한다.

- 전체 프레임워크 관점에서, EMO는 다양한 모듈(diversified modules) 없이 오직 iRMB만으로 구성된다➁. 이는 최근의 효율 모델들과 비교했을 때 설계 아이디어 측면에서의 차별점이다.

- 특정 모듈 관점에서, iRMB는 표준 convolution과 multi-head self-attention(MHSA) 만을 포함하며, 그 외의 복잡한 연산자(complex operators)를 사용하지 않는다➀. 또한 DW-Conv의 이점을 통해, iRMB는 stride를 이용하여 down-sampling 연산에 자연스럽게 적응할 수 있으며, MHSA에 귀납적 편향(inductive bias)을 도입하기 위한 position embedding이 필요하지 않다➁.

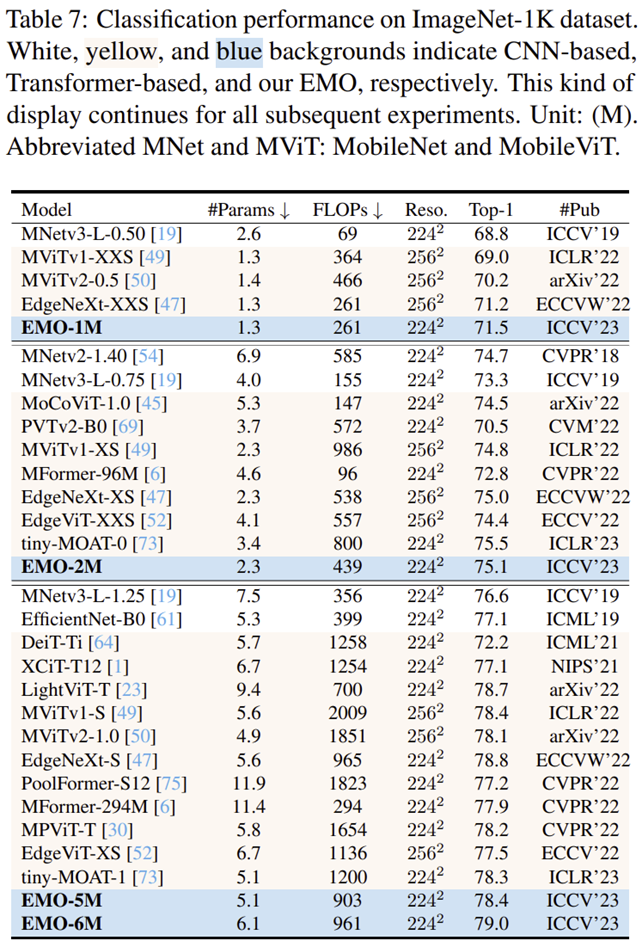

- 변형(variant) 설정에서는, 우리는 expansion rate(확장비) 와 channel number(채널 수) 를 단계적으로 증가시키는 구성을 사용하며, 자세한 설정은 Table 4에 제시한다. 기본 분류(ImageNet) 및 다수의 downstream task 결과는, 1M, 2M, 5M 규모에서 우리 EMO가 SOTA 경량 방법들보다 우수함을 보여준다➂➃.

4-1) Details

MHSA는 더 깊은 층에서의 semantic feature 모델링에 더 적합하므로, 기존 연구들을 따라 stage-3/4에서만 MHSA를 켠다. 이는 uniformity 기준을 위배하지 않는데, MHSA를 끄는(shutdown) 설정은 iRMB 구조의 특수한 경우 로 볼 수 있기 때문이다. EMO의 안정성을 더 높이기 위해, BN+SiLU는 DW-Conv에 결합시키고, LN+GeLU는 EW-MHSA에 결합시킨다. 또한 iRMB는 down-sampling 연산도 충분히 수행 가능하다.

4-2) Relation to MetaFormer

- 구조 관점에서, MetaFormer를 확장한 dense prediction 모델은 down-sampling을 위해 추가적인 patch embedding layer를 사용하는 반면, EMO는 오직 iRMB로만 구성된다.

- 결과 관점에서, 인스턴스화된 EMO-5M(5.1M #Params, 903M FLOPs)은, 인스턴스화한 PoolFormer-S12(11.9M #Params, 1,823M FLOPs)보다 +1.2↑ 더 높은 성능을 보인다. 이는 더 강력한 efficient operator가 이점을 만든다는 점을 보여준다.

- MetaFormer의 Token Mixer를 iRMB의 $\mathcal{F}$ 로 대체하여 5.3M 모델을 구축하고, 이를 EMO-5M과 비교했다. 그 결과 해당 모델은 ImageNet-1k에서 Top-1 77.5를 달성했으며, 이는 EMO 대비 -0.9↓ 낮다. 이는 제안한 Meta Mobile Block이 두-residual MetaFormer보다 경량 모델 구성에 더 유리한 장점을 가진다는 의미이다.

4-3) Importance of Instantiated Efficient Operator

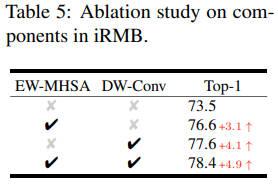

efficient operator $\mathcal{F}$ 는 두 가지 핵심 모듈, 즉 EW-MHSA와 DW-Conv를 포함한다. Table 5에서 두 모듈의 영향을 보기 위한 ablation을 수행한다.

- 첫 번째 행은 EW-MHSA도 DW-Conv도 사용하지 않는 경우를 의미한다. 즉 모델은 down-sampling을 위한 몇 개의 DW-Conv를 제외하면 거의 MLP layer로만 구성되며, 이때 $\mathcal{F}$ 는 Identity operation으로 퇴화한다. 놀랍게도 이 모델도 Top-1 73.5라는 준수한 결과를 낸다.

- 두 번째/세 번째 행의 결과는 각 구성요소가 성능에 기여함을 보여준다. 예를 들어, DW-Conv를 추가하면 +3.1↑, EW-MHSA를 추가하면 +4.1↑의 향상이 나타난다.

- 두 구성요소를 모두 사용할 때 Top-1 78.4로 최상의 결과를 달성한다.

이 실험은 iRMB의 구체적 인스턴스화가 모델 성능에 매우 중요함을 보여준다.

4-4) Order of Operators

EMO-5M을 기반으로 DW-Conv/EW-MHSA의 순서를 바꾸면 성능이 소폭 하락(-0.6↓)한다. 따라서 기본 설정에서는 EW-MHSA가 먼저 수행되도록 한다.

Experiment Results

1) Image Classification

2) Object Detection

3) Semantic Segmentation

4) Efficiency Analysis

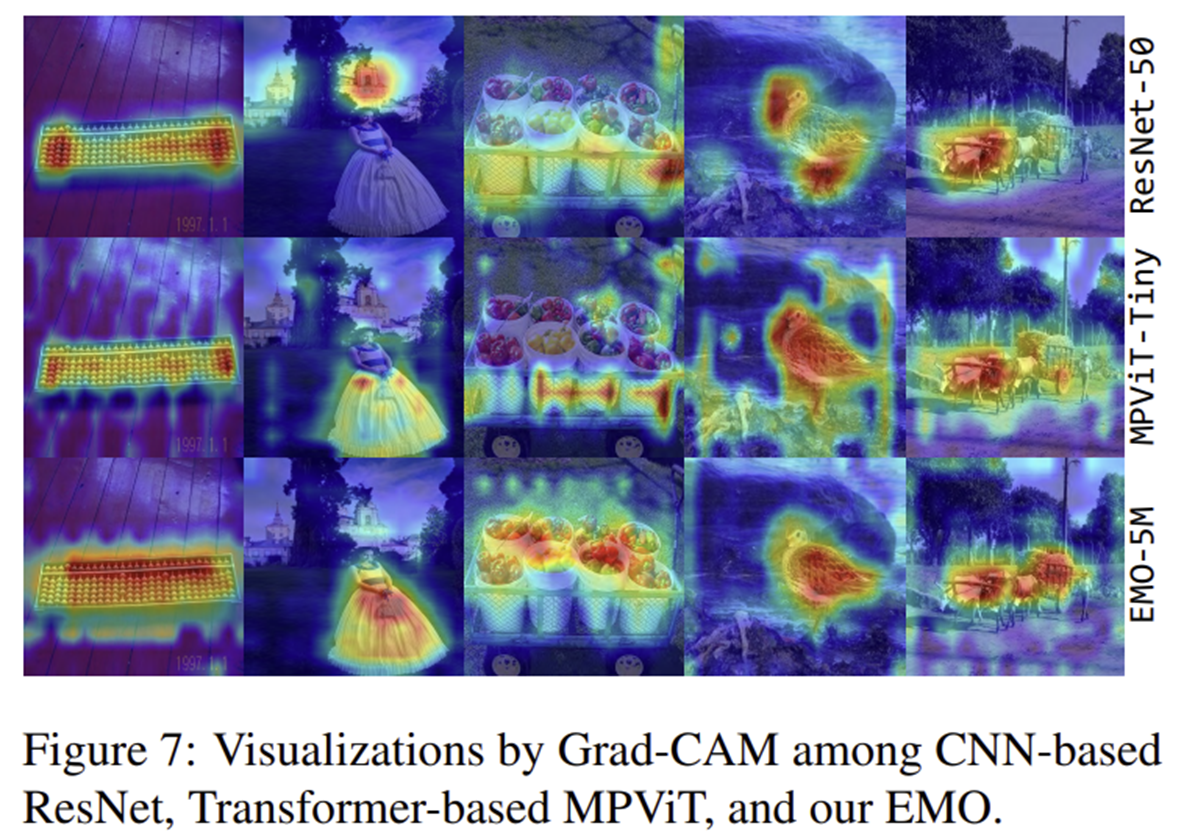

5) Feature Visualization