안녕하세요. 오늘 리뷰할 논문은 'Improved Regularization of Convolutional Neural Networks with CutOut'로 arxiv에 공개적으로 출판되어있는 논문입니다. 해당 논문은 제목에서도 알 수 있다싶이 Data Augmentation 중 CutOut이라는 방법을 제안한 논문입니다.

Improved Regularization of Convolutional Neural Networks with Cutout

Convolutional neural networks are capable of learning powerful representational spaces, which are necessary for tackling complex learning tasks. However, due to the model capacity required to capture such representations, they are often susceptible to over

arxiv.org

인공지능은 현재 다양한 분야 (Object Recognition, Semantic Segmentation, Image Capturing, Human Pose Estimation 등)에 걸쳐 state-of-the-art 성능을 보이고 있습니다. 이러한 AI의 눈부신 발전은 합성곱 신경망 (CNN)이라고 해도 과언이 아닙니다. CNN은 입력 영상으로부터 학습가능한 파라미터를 통해 최적인 특징 맵을 추출함으로써 영상의 계층적 특징을 학습할 수 있죠. 그런데, 이러한 가정은 데이터가 충분히 많은 경우에 한정적 입니다. 데이터는 적으나 모델의 복잡성이 증가하게 되면 그만큼 과적합 (overfitting)이 발생할 가능성이 증가하여 일반화 성능이 감소하게 됩니다.

이러한 문제를 해결하고자 훈련 데이터셋으로부터 새로운 데이터셋을 만드는 data augmentation (DA)은 굉장히 각광받고 있습니다. 가장 단순한 DA는 입력 영상을 회전, 뒤집기, 색깔 변환 등과 같은 sptial 및 intensity transformation들을 생각할 수 있습니다. 실제로 이전에 리뷰했었던 VGGNet에서 이러한 변환을 적극 활용하였죠.

이번에는 다른 문제를 생각해보도록 하겠습니다. 과거에도 문제였고 현재에도 CNN이 어려워하는 것은 객체 폐색 (object occlusion)입니다. 즉, 저희가 감지해야하는 객체가 어떤 대상에 의해 약간 가려져있는 경우를 의미합니다. 이러한 경우에는 CNN이 객체를 정확하게 인지하는 것이 어렵죠. 본 논문은 이 부분에 motivation을 얻게 됩니다.

그렇다면 occlusion된 영상을 CNN에 많이 보여주면 되지 않을까?

그렇게 탄생하게된 CutOut은 매우 단순한 알고리즘으로 높은 성능 향상을 얻게 되었죠.

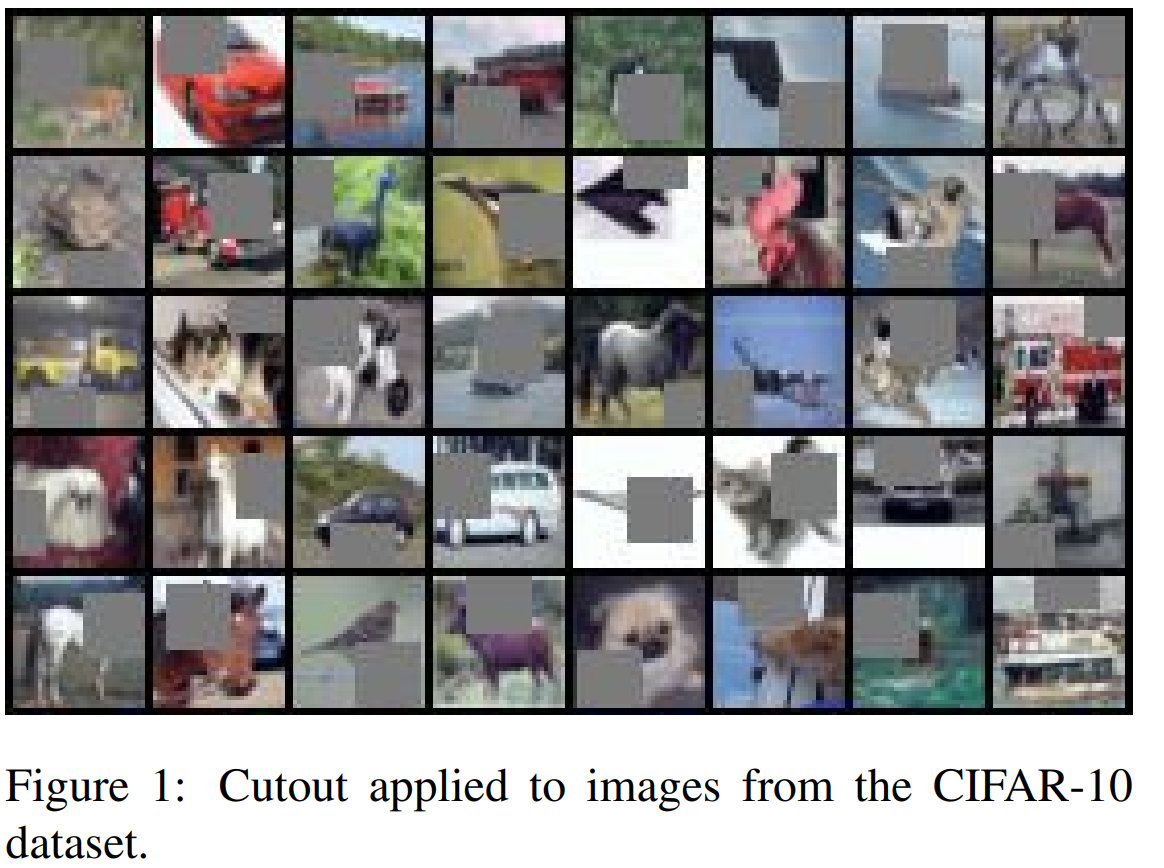

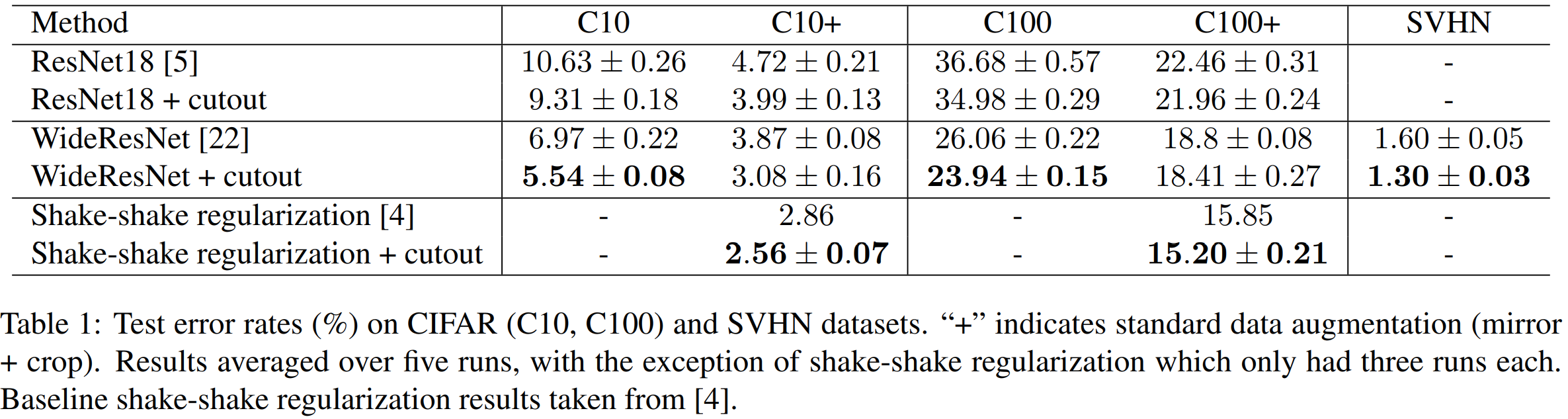

위 그림은 CIFAR-10 데이터셋에 CutOut을 적용한 다양한 영상들을 보여주고 있습니다. 본 논문에서는 총 3가지의 대표적인 CNN 모델인 ResNet-18, WideResNet-40-2, Shake-Shake를 이용하여 검증하였습니다.

실험 결과는 baseline과 비교했을 때 SVHN을 제외한 데이터셋에 대해서 1% 이상 더 감소한 Top-1 Error rate를 얻을 수 있었습니다.